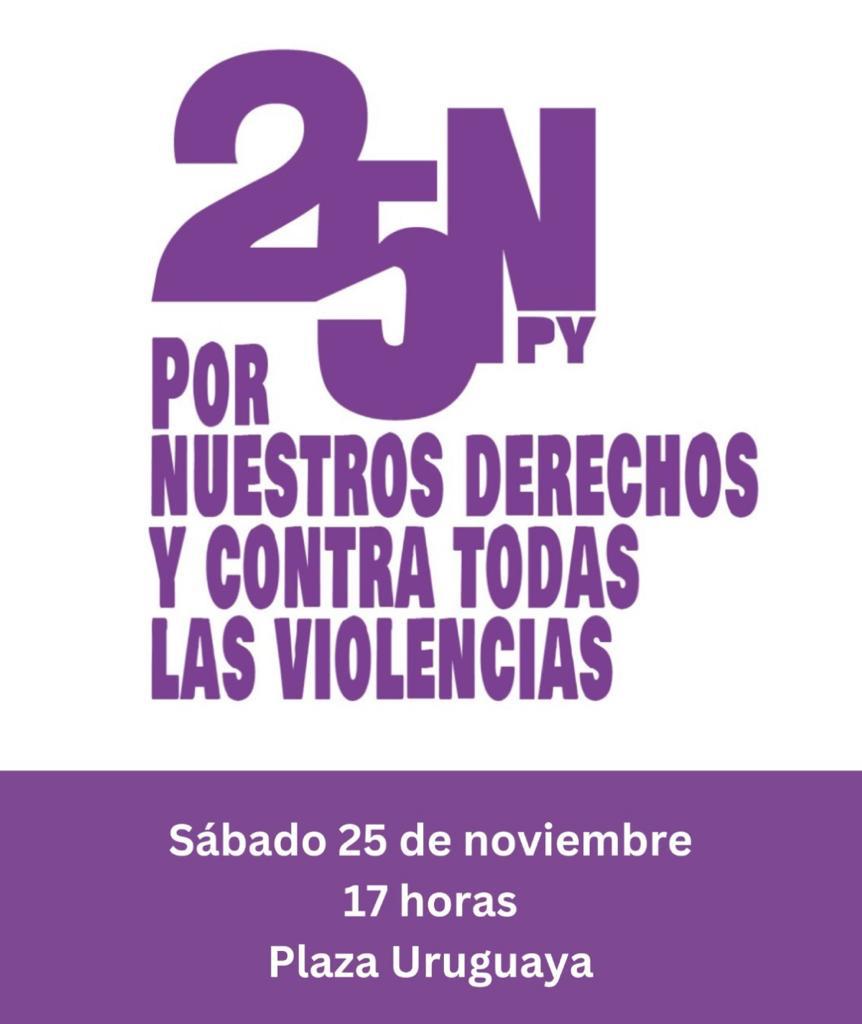

* Imagen perteneciente al sitio de la campaña. Disponible acá.

Si bien el avance de las tecnologías en las últimas décadas tuvo su enfoque en la mejora de comunicación y acceso a la información, hoy en día, el avance tecnológico se encuentra enfocado en el desarrollo de Inteligencia Artificial para aumentar la autonomía en la toma de decisiones. La implementación de tecnología autónoma ya existe en las áreas de infraestructura, transporte, agricultura, espacio, arquitectura, y se encuentra en fuerte desarrollo por parte del sector militar de los gobiernos de Estados Unidos, China, Israel, Corea del Sur, Rusia y el Reino Unido. Principalmente como sistemas de armamento autónomo para la selección de objetivos de ataque, conocidas como sistemas de armas letales autónomas o robots asesinos. Con el desarrollo de estas armas robóticas, se plantea reemplazar a tropas por máquinas autónomas con mínimo o nulo nivel de intervención humana, que podrán seleccionar y atacar objetivos, tomando decisiones sobre dónde y cómo se utilizan y a quiénes atacar.

De ser permitido el uso de estas armas autónomas, se daría pie a problemáticas que vulneran una serie de derechos humanos y ponen en riesgo a la humanidad. Para brindar una respuesta coordinada frente a estas múltiples problemáticas, a partir del 2013 se estableció una Campaña Global para Detener a los Robots Asesinos (Stop Killer Robots), liderada por una coalición de organizaciones no gubernamentales que trabajan para retener el principio del control humano sobre el uso de la fuerza. La misma se inscribe en otras iniciativas internacionales que impulsan organizaciones sociales y otros actores para generar un mundo seguro para todas y todos.

Este miércoles 25, jueves 26 y viernes 27 de febrero se llevará a cabo una segunda reunión global sobre la Campaña que permitirá contribuir al fortalecimiento de las acciones globales, regionales y locales, y así avanzar hacia un tratado que prohíba el uso de las armas totalmente autónomas. La misma tendrá lugar en Buenos Aires, Argentina. TEDIC hará parte de dicha reunión por lo que escribimos este post para compartirte las razones por las cuáles la creación y uso de estas armas letales autónomas representan un grave peligro y por qué deben prohibirse. También te proponemos acciones para poder colaborar a la campaña desde distintos sectores.

Problemas principales

En la primera reunión que la campaña realizó en Londres en el 2013, se delinearon algunas de las razones por las cuales el uso de las armas letales autónomas son problemáticas:

- Problemas de grado de discriminación: Los robots poseen un cierto grado de discriminación, pero no pueden discriminar o distinguir entre un soldado o un ciudadano. No cuentan con la capacidad de juicio humano, por ende no pueden hacer esta distinción, lo cual abre las puertas muchos errores y conflictos con consecuencias nunca antes vistas que podrían avivar las tensiones existentes entre países.

- Problemas de cálculo y evaluación de proporcionalidad de un ataque: Los robots no pueden realizar los cálculos de proporcionalidad requeridos bajo el Derecho Internacional Humanitario, el cual apunta a limitar los efectos de los conflictos armados, y se refiere a la noción de que los accidentes civiles son aceptables bajo ciertas circunstancias, siendo que es directamente proporcional a la ventaja militar que es ganada al realizar un ataque. Esto requiere un comando humano para tomar una decisión basada en su propia experiencia, conocimiento, instinto y sentido común.

- La falta de limitación de su uso en determinadas circunstancias: Las armas enteramente autónomas podrían ser utilizadas en circunstancias fuera de campos de batalla y de conflicto armado, como en controles de fronteras y vigilancia. Podrían ser utilizadas para deshacer protestas y sostener regímenes. La fuerza que se supone que no es letal, podría de igual manera provocar muchas muertes. Considerando el historial de violencia a la hora de disolver protestas y revelarnos ante regímenes sin siquiera contar con el uso de este tipo de armas, la implementación de las mismas es sumamente preocupante, ya que vulnera nuestros derechos.

- Brecha de responsabilidad y rendición de cuentas: Una acción en el campo de guerra proveniente de una orden realizada por un humano cuenta con un grado y noción de responsabilidad y rendición de cuentas, mas no así con el caso de estos robots considerados enteramente autónomos. ¿A quién se le atribuye la responsabilidad ante una acción ilegal? ¿A los que crearon o programaron al robot, o a las empresas que las venden? ¿O a los jefes militares? ¿O a la máquina en sí? Ya que esto no queda claro, las líneas de responsabilidad y rendición de cuentas se ven impactadas por una brecha que solamente complicaría el uso de la justicia, en especial para las víctimas.

- La falacia de crear guerras “sin sangre”: No es seguro que las guerras en donde se implementen estos robots no representen un daño para la ciudadanía. Además, reemplazar las tropas por máquinas autónomas haría que la decisión de entrar en guerra fuera mucho más sencilla, y considerando la incapacidad de los robots de distinguir entre soldados y civiles, desplazaría más la carga del conflicto hacía los civiles.

- El riesgo de la proliferación masiva de este tipo de tecnología: En guerras en donde hayan robots de cada lado, la competitividad aumentará, lo cual también impacta en cuestiones de cantidad y frecuencia de uso de los mismos. Acá aumenta el riesgo de daño colateral, así como también las probabilidades de que este tipo de armas pueda incluso a llegar a manos de los ciudadanos, causando daños catastróficos.

- El aspecto impredecible de los campos de batalla y lugares de conflicto armado: El programa diseñado, el cual se basa su proceso de toma de decisiones en escenarios predecibles, no tiene en cuenta lo impredecible de los campos de batalla. Tampoco existe conocimiento sobre la manera en la que los programas de estos robots reaccionarían ante casos de fallo de programa, hackeo o desestabilización. Los riesgos de que los robots puedan causar conflictos por problemas de software y por las razones anteriormente mencionadas es muy alto.

- Cruce de límites morales: Sin contar con el factor de la intervención humana, estos robots serán los únicos que decidirán quiénes viven y/o mueren, lo cual cruza los límites morales. También cabe mencionar la falta de características inherentemente humanas necesarias para la toma de decisiones éticas complejas, como por ejemplo, la compasión.

Soluciones y recomendaciones propuestas por la campaña

Ante las problemáticas mencionadas, la campaña propone la prohibición del desarrollo, producción y uso de estas armas como la mejor solución. Esto es seguido además por las siguientes recomendaciones:

- Conservar un control humano sobre la determinación de objetivos y decisiones de ataque al prohibir el desarrollo, producción y uso de armas enteramente autónomas

- Legislar la prohibición mediante leyes nacionales y tratados internacionales

- Todos los países deberían comprometerse a articular sus puntos de vista sobre sus inquietudes referentes a las armas enteramente autónomas y comprometerse a crear un tratado de prohibición que establezca el principio del control humano sobre el uso de la fuerza

- Lograr un compromiso de parte de las organizaciones y empresas tecnológicas, así como también de individuos trabajando para desarrollar inteligencia artificial y robótica, a evitar contribuir al desarrollo de armas autónomas.

Cómo accionar y colaborar a la campaña

- Podés donar a la campaña: https://donate.hrw.org/page/37038/donate/1

- Podés contactar al gobierno y preguntar si ellos apoyan la prohibición de estas armas autónomas

- Compartir la campaña a través de las redes sociales y/u otras plataformas:

- Instagram: @stopkillerrobots

- Twitter: @BanKillerRobots / @SehlacOrg

- Facebook: @stopkillerrobots

- Youtube: Campaign to Stop Killer Robots

- LinkedIn: Campaign to Stop Killer Robots

- Si sos parte de una organización no gubernamental, podés hacer que la organización se convierta en miembro de la campaña enviando un correo al personal de la campaña (admin@stopkillerrobots.org) sin costo alguno.

- Si sos un representante de gobierno, debés respaldar y trabajar a favor de la prohibición del desarrollo y uso de las armas autónomas.

- Si formas parte del sector privado y de una empresa tecnológica, podés accionar para que las empresas puedan comprometerse públicamente a no participar en el desarrollo de armas autónomas, y también solicitar la prohibición de las mismas.

- Si sos una persona experta y trabajás con tecnología, inteligencia artificial, robótica y campos relacionados, podés unirte al Comité para Control de Armas Robóticas, co-fundador de esta campaña.

Para más información y recursos sobre sobre la campaña, podés acceder al sitio web de la misma. También, podés seguir nuestras publicaciones en las redes sobre las novedades y acuerdos que resulten en este segunda reunión global en Buenos Aires. Podés también seguir la agenda y los eventos de la campaña acá.

MARCO REGULATORIO DE DATOS PERSONALES – CASO DE LA UNIÓN EUROPEA

MARCO REGULATORIO DE DATOS PERSONALES – CASO DE LA UNIÓN EUROPEA  Marcha #25NPY

Marcha #25NPY  El ABC de nuestra comunidad en 2023

El ABC de nuestra comunidad en 2023